- 易迪拓培训,专注于微波、射频、天线设计工程师的培养

一种微光视频处理系统的设计方案

0 引言

微光视频系统在夜视技术上用途越来越广泛,然而由于目标照度很低、目标和背景反射系数很接近、观察环境不好等恶劣的条件下,得到的微光视频图像总是得不到满意的效果。我国现有的硬件生产能力的条件下,微光像增强器还达不到应用化的效果,但是实时图像处理技术能迅速提高微光系统的图像质量,增加微光视频系统的视距,因此把实时图像处理技术与像增强技术相结合成为缩短国内外微光视频系统差距的一个重要发展方向,本文在达芬奇平台TMS320DM6446上实现了微光视频的实时处理系统,对我国的微光视频系统设计有重要的参考价值。

1 微光视频增强技术

微光视频最显着的表现特征是在图像画面上叠加有明显的随机闪烁噪声,通过对微光视频的特征和噪声进行分析,可以从增大微光视频的对比度和减少微光视频的噪声两方面来设计微光视频增强系统。由于系统的特点,需要采用简单有效的处理算法。直方图均衡化是增大图像对比度的经典算法,而且算法简单、处理效果较好;高斯平滑算法能有效地去除图像的高频分量而保留低频分量,这两种算法与嵌入式处理平台结合使用,可以获得很好的效果。本文在设计中使用软件的设计方法来达到图象增强技术。

2 基于达芬奇平台的微光视频系统

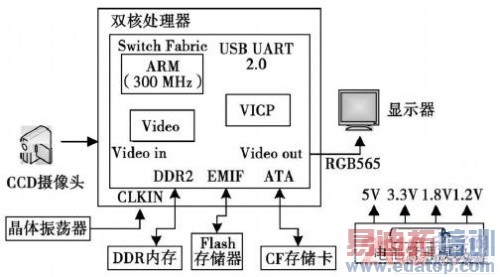

微光视频系统的特点是在实时采集和实时显示的基础上,实现微光视频的增强处理和去噪处理,达到实时处理的要求,因此需要较强的实时处理的和数据处理能力,这里选择TI公司具有DSP+ARM双核处理功能的的达芬奇平台(TMS320DM6446)可以满足上述的要求。

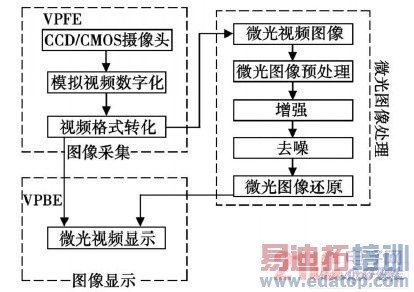

微光视频实时处理系统中,微光视频的采集、处理和显示过程是通过TMS320DM6446平台上的CCD/CMOS摄像头或者是图像解码器,对微光视频实时采集并进行数字化转换后,存储在读缓冲区中,用户可以利用TMS320DM6446的数字媒体处理器完成微光视频的实时处理任务,并将处理后的微光视频通过嵌入式处理平台上的显示设备进行实时显示。微光视频实时处理系统的原理如图

1所示。

图1 微光视频实时处理原理图

在本微光视频实时处理系统中,微光视频实时采集部分由视频采集设备和视频解码芯片完成;微光视频实时处理部分由TI公司的TMS320 DM6446双核处理器完成;微光视频实时输出系统由LCD显示器和视频编码器完成。

2.1 微光视频图像的采集

论文中模拟视频数字化标准ITU-RBT.656,它是在ITURBT.601(CCIR-601)的基础发展的一种新的视频数字化标准。由于 CCIR656视频数据流采用8根信号线(传统方式需要19根信号线)就可以传输所有的图像信息和行同步、场同步、偶同步信息,因此采用CCIR656方式进行接口设计时,便于实时数字图像处理硬件平台以功能单元为单位进行模块化设计。

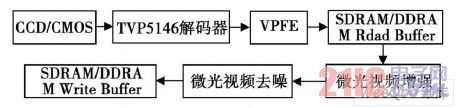

图2 微光视频采集模块结构图

通过CCD/CMOS视频采集设备采集模拟的微光视频,视频为PAL或者NTSC制式,模拟视频通过解码芯片TVP5146与CCD控制器的BT.656接口进行A/D转换,转化为YCrCb格式的视频,同时将采集的微光视频通过外部存储器接口(Extmal Memory Interface,EMIF)缓存在DDRAM或SDR-AM中的读缓冲区中,以便微光视频处理模块对采集的数据进行处理。

2.2 微光视频处理功能的设计

根据视频格式,然后将该分量从RGB格式转换为YUV格式,再在嵌入式处理平台中对该分量讲行处理,处理完毕后用该分量代替Y分量,将灰度图像转换为彩色图像进行输出等操作。视频处理模块的结构如图3所示。

图3 微光视频处理模块结构图

采集模块采集完一帧微光视频后,视频处理模块从DDRAM/SDRAM中的读缓冲区(Read Buffer)中获取一帧微光视频,依次对微光视频进行增强和去噪处理,处理后再次缓存在DDRAM或者SDRAM中的写缓冲区(Write Buffer)中,供显示模块使用。

2.3 微光视频显示功能的设计

在本系统中我们利用了Framebuffer技术和达芬奇的视频处理子系统VPSS技术对图像进行显示。Framebuffer即帧缓冲区,是Linux内核中的一种驱动程序接口,这种接口将显示设备抽象为帧缓冲区。用户可以将它看成是显示内存的一个映像而不必关心物理显存的位置、换页机制等具体细节。因为这些细节都是由Framebuffer设备驱动来完成的。程序员只要将要显示的图像映射到进程地址空间,它便显示在屏幕上。显示模块的结构图如图4所示。

图4 微光视频显示模块结构图

采集模块采集到的视频经过处理模块进行增强和降噪处理后,利用内存映射的方式,使用FrameBuffer技术进行显示。 来源:电子科技