- 易迪拓培训,专注于微波、射频、天线设计工程师的培养

基于已标定摄像机的车辆识别系统

摘 要: 现有车辆类型识别系统中,由于摄像机未经过标定,使得在图像分析中无法得到关于尺度和坐标的真实数据,从而带来了一系列问题。鉴于此,提出了基于已标定摄像机的车辆识别系统,并结合特定车辆的3D模型,规划设计了逃逸车辆的在线识别方案。摄像机标定后,可以自动检测车辆的真实大小和在世界坐标中的真实运动方向,不但能够更为准确地进行车辆识别,而且为实现摄像机之间的联合检测和接力检测提供了数据基础。最后从摄像机标定过程中的重投影误差分布图以及基于玩具车的模拟测试说明了基于摄像机参数和车辆模型动态生成车辆视图的可行性。

关键词: 特定车辆;识别;标定摄像机;3D模型

0 引言

关于车辆类型识别的方法已经提出了很多。基于地埋感应线圈的车型识别技术[1-2]只能对车型给与大致的区别,不能根据车外观造型、颜色等进行细分。基于地埋压电传感器的车型识别技术[3]只对重量检测比较合适。基于红外线检测的车型识别技术[4]通过有无反射波来对过往车辆进行检测,鉴于速度这个不确定因素,也只能大致检测。基于视频图像的车型识别技术通过摄像机采集视频图像,它可以获得更为丰富的车辆信息,因此可以作更全面和准确的车辆分类,同时检测器安装简便、监控范围广。实际上,数字图像和数字视频技术常被用于道路车辆的视频监控、车牌识别、路况分析、车辆识别等。

然而目前的车辆监控系统大多数采用单摄像机拍摄图像,并且摄像机参数没有经过标定。这使得对图像内容的处理过程中缺乏真实尺度信息,车辆的真实大小、运行的实际空间方向无法获知,对车辆识别造成困难,也使得车辆的全程跟踪无法实现。为此,本文提出采用已标定摄像机和车辆3D模型的方法,并对其中的技术原理和系统模型进行了分析设计。

1 现有车辆识别中存在的问题

基于视觉的目标检测,通常是通过统计车辆的某种特征来比对识别的。一般的处理步骤是,首先根据运动信息分割车出辆区域,然后根据车辆的各种数据进行判决,这些特征信息可能是车辆图像几何参数特征[5-7]、代数特征值、矩特征[8]、变换系数特征[9-11]、图像特征点特征[12-13]。对这些特征进行判别的方法,常用的主要有:(1)最小距离分类法,例如采用角点的Hausdorff距离;(2)隐马尔可夫模型识别方法;(3)支持向量机识别方法;(4)人工神经网络[14]等。有的学者[15-16]采用一种基于三维结构模型的车辆特征提取方法,为车辆建立一个参数模型,并提出了利用3D几何模型来对车辆运动跟踪的方法[17]。

上述的方法策略中,都是基于未标定的摄像机,所存储的视频序列数据库中不包含摄像机的参数信息。未标定的摄像机会带来较大的难度:(1)对象的实际尺寸无法获知;(2)无法获知车辆的运行方位;(3)在处理多摄像之间的视频衔接时,也需要人工判断和比对。因此,本文将未标定摄像机改为已标定摄像,并将摄像机的内外参数与其所拍摄的视频数据同时存储。

2 已标定摄像机系统及其作用

目前视频监控以单摄像机为主,也有采用双摄像机或者多摄像机同时监控的。但是在系统设计时,摄像机之间没有相关性。双目摄像机系统可以记录和重建目标的三维空间信息[18],从而为视频对象的处理带来极大的便利。

通常的摄像机都不可能是理想的摄像机,例如焦距与标称值有误差,焦距在水平和竖直方向上不一致,图像的主点不在图像的中心,拍摄的图像存在径向和切向的畸变。对于双目摄像机,还存在两个摄像机的参数不一致、距离标定问题。这些参数被划分为内部参数intrinsic和外部参数extrinsic,它们可以通过摄像的标定算法计算出来[19]。这些参数包括每个摄像机的内部参数intrinsic以及摄像机之间的外部参数extrinsic,另外还需要知道世界坐标相关数据。

intrinsic={Fx,Fy,cx,cy, 酌,k1,k2,k3,p1,p2}

extrinsic={ 兹x, 兹y, 兹z,tx,ty,tz}

依据摄像机的内部和外部参数,可以进一步通过立体校正,将两个摄像机的参数校正到左右一致的虚拟参数上,这时两个实际的摄像机可被看作一套理想的立体摄像机系统,只需要{F,cx,cy,tx}这4个参数。这4个参数可写成一个4×4矩阵的形式,它可以在视差d已知的情况下由图像m(x,y)坐标计算出三维空间坐标■=[X,Y,Z,1]T,如式(1)所示,■为齐次坐标形式,其中比例参数s可以在求解的过程中消掉。

![9%6~I8{ON%~D`FB$]ACDXBX.png 9%6~I8{ON%~D`FB$]ACDXBX.png](http://www.edatop.com/uploadfile/2017/0630/20170630084301595.png)

实际上,单摄像机系统是最常用的。它不能像双摄像机系统那样在摄像机参数已知的情况下直接计算出三维目标的尺寸及其世界坐标位置,但是对于“路面交通”这样的应用环境,也是有所作为的,因为车辆都位于路面上,所以只考虑路面到摄像机像平面的映射即可。不妨假定Z=0,则像素坐标m(x,y)与地面世界坐标![XMQJ31Q]@)X4}Z[RB151Z(2.jpg XMQJ31Q]@)X4}Z[RB151Z(2.jpg](http://www.edatop.com/uploadfile/2017/0630/20170630084302704.jpg) π=[X,Y,1]T之间可以通过一个3×3的单应性矩阵H联系起来,如式(2)所示,这个关系是可以进行逆运算的。

π=[X,Y,1]T之间可以通过一个3×3的单应性矩阵H联系起来,如式(2)所示,这个关系是可以进行逆运算的。

![8QHAK~G]TIT~7M66E8BOS[M.png 8QHAK~G]TIT~7M66E8BOS[M.png](http://www.edatop.com/uploadfile/2017/0630/20170630084302764.png)

对于车辆检测应用系统[20-21],无论是双摄像机系统还是单摄像机系统,都可以建立图像像素坐标到空间目标坐标之间的对应计算关系,可以通过像素坐标来计算空间坐标。这样,可以在摄像机参数已知的情况下实现:

(1)计算空间目标的位置(X,Y,Z),从而确定车辆在世界坐标中的真实位置;

(2)计算目标的实际大小,从而为车辆类型的判别提供重要依据;

(3)通过车辆在摄像机视场中真实位置,可以根据车辆模型和摄像机参数生成用于车辆识别的车辆视图;

(4)可以判断车辆在真实世界中的运行方向和速度。

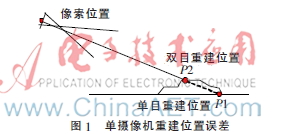

这其中最为关键的是对车辆位置的计算。两者相比之下,双目摄像机可以提供更为准确的三维重建,它可以计算像素点的真实三维空间位置,X、Y、Z 3个坐标值都可以计算出来,如图1中的P2点。而单摄像机系统在目标位置定位的过程中会造成较大的误差。单目相机将像素点全部映射到地面上,而实际的车辆都有一定的高度,因此会带来误差,如图1中的点P1。

3 基于已标定像机的特定车辆识别

采用基于3D模型的方法对特定车辆进行识别,由于车辆在摄像机视场中处于不同的位置时,实拍车辆图像会有很大不同,为了准确生成对应的模型图像,需要对车辆的位置和方向角度进行检测。同时,为了便于监控场点之间的连续性跟踪,需要建立基于GPS的全局坐标系系统。

3.1 坐标系统模型

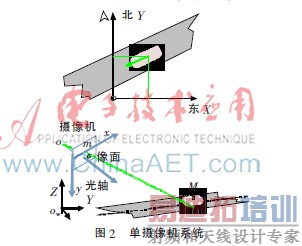

为了不增加硬件成本,采用目前已经在运行的单摄像机系统,如图2所示。全网的摄像机采用统一模式的“局部世界坐标”系统。即以正北方为Y轴,以正东方为X轴,线杆与地面的交点为原点,Z轴垂直于地面竖直向上,也就是坐标系的XY平面建立在地平面上,从而确定了此摄像机局部世界坐标(OwXYZ)。

同时,通过全球定位系统GPS测量出Ow的经纬度坐标以确定局部世界坐标在世界坐标中的位置Ow=(Xgps,Ygps,0)。因此,需要以下参数来描述摄像机:

cam_para={intrinsic,extrinsic}Ow={Xgps,Ygps,0}

其中,内部参数intrinsic描述摄像机自身的属性,外部参数extrinsic描述了该摄像机在局部世界坐标中的位置和方向,而Ow确定了局部世界坐标在全局世界坐标中的位置。

预先对各个路口的摄像机进行标定,获取内部参数和外部参数,并同时存储在摄像机机身中和服务器的“摄像机参数”数据库中。通过摄像机标定算法,可以计算出该摄像机的内部和外部参数。

3.2 系统工作原理

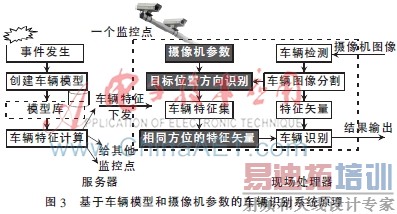

需要针对逃逸车辆建立3D模型,并计算其特征数据,然后通知所有摄像机按照特征数据检查过往车辆,并实时报警。而创建一种车辆的视觉3D模型也不是一件很难的事情,因为这种模型只需要提供外观特征,而不必关心车身内部。车辆模型建立后可以存入模型库以备下次直接调用。系统工作原理如图3所示。

从图3可以看出,当追逃任务下达后,服务器根据待查车辆的类型调出车辆3D模型,依据各个监控场点的摄像机参数生成目标车辆的多张参考图像,并将它们发送给各个摄像机,摄像机依据这些图像进行在线识别。因为图像的数据量比较大,所以实际系统中也可以由服务器根据图像计算出特征矢量,然后将特征矢量数据发送给摄像机,以便减小通信压力。可有以下3种实现策略。

(1)现场实时分析

将3D模型下发给各个摄像机的现场处理器,由现场处理器生成特定视图及其特征矢量数据。这是最理想的方案,但是目前由于现场处理器计算能力和内存容量的限制,这种方案难以实现。

(2)服务器实时分析

摄像机实时检测车辆的距离和方位,然后要求实时生成特定视图及其特征矢量数据,并发送给摄像机,这种模式对通信能力的要求过高。

(3)服务器预分析

服务器根据每个摄像机的参数预先生成可能的视图及其特征矢量,然后下发给摄像机。服务器不可能把所有可能的视角图像都预先生成,为此,将俯视角 茁和侧视角 琢都划分为9个子角度,这样总共有81种视角,对每个视角生成视图并计算其特征矢量,然后传送给摄像机。

3.3 仿真结果分析

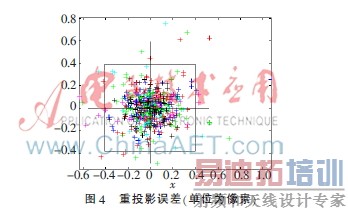

图4是在进行摄像标定的过程中由MATLAB输出的标定物重投影误差分布图,可以看出在通常精度情况下重投影误差绝大多数在±0.4像素之内。这说明,根据3D模型和摄像机参数生成的视图与真实拍摄图像之间会有很好的符合度,甚至可以在半像素精度之内。实际上在图像分析处理的过程中往往会带来一定程度的误差,需要通过一定的算法来尽可能减小这一误差。

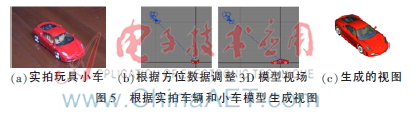

图5是根据摄像对实拍图像的检测结果,然后根据检测数据由人工输入3D MAX产生的视图,可以看出结果非常吻合。这种情况下,不但可以采用各种尺度和旋转不变量来进行识别,也可以直接采用图像匹配的方法,因为这时不必担心模型图像与实拍图像在尺度、视角上的区别。

4 结论

本文提出了基于已标定摄像机的车辆识别系统,并结合特定车辆的3D外观模型,规划设计了逃逸车辆的在线识别方案。由于摄像机标定后可以自动检测车辆的真实大小和在世界坐标中的真实运动方向,不但能够更为准确地进行车辆识别,而且为实现摄像机之间的联合检测和接力检测提供了数据基础。通过基于玩具车的模拟测试可以看出,依据摄像机参数和真实车辆图像,能够生成与真实图像几乎完全一致的车辆视图。另外,从标定过程中的重投影误差分布图可以看出,重投影误差大部分在半像素精度之内。因此只要能够对真实图像中的车辆位置和方位角作出准确的检测,就可以依据模型创建合适的视图,从而使得车辆的识别算法更为简单和准确。

参考文献

[1] TOK Y C A. Commercial vehicle classification system using advanced inductive loop technology[D]. Irvine: University of California, 2008.

[2] 朱海涛.一种基于感应线圈的车型识别系统[D].成都:西南交通大学电气工程学院,2003.

[3] 徐威.基于红外检测和压电传感相结合的车型自动分类技术研究[D].南京:南京理工大学电子工程与光电技术学院,2004.

[4] 顾国华.车辆红外自动识别技术与系统研究[D].南京:南京理工大学电子工程与光电技术学院,2000.

[5] Tao Jinsong, Chen Shixiu, Yang Li, et al. Ultrasonic technique based on neural networks in vehicle modulation recognition[J]. Intelligent Transportation Systems,2004(42):201-204.

[6] 张小军.智能交通系统中的车辆检测和车型识别技术研究[D].西安:西北大学,2006.

[7] Wei Zhan, Zhiqing Luo. System design of real time vehicle type recognition based on video for Windows(AVI) files[C]. Intelligent Computing and Information Science, Communications in Computer and Information Science, 2011,135:681-686.

[8] HU M K. Visual pattern recognition by moment invariants[J]. IRE Transactions on Information Theory,1962(8):179-187.

[9] KAZEMI F M, SAMADI S, POORREZA H R, et al. Vehicle recognition using curvelet transform and SVM[J]. Fourth International Conference on Information Technology, ITNG′07, 2007:516-521.

[10] KAZEMI F M, SAMADI S, POORREZA H R, et al. Vehicle recognition based on Fourier, Wavelet and Curvelet transforms-a comparative study[J]. Fourth International Conference on Information Technology, ITNG′07, 2007:939-940.

[11] Zhou Zhuyu, Deng Tianmin, Lv Xianyang. Study for vehicle recognition and classification based on gabor wavelets transform & HMM[C]. 2011 International Conference on Consumer Electronics, Communications and Networks (CECNet), 2011:5272-5275.

[12] 杨雪.基于视觉感知的图像显著区域的提取[J].微型机与应用,2015,34(2):47-48,51.

[13] 严明,李玉惠,李勃,等.高速公路监控视频中运动车辆对象提取[J].微型机与应用,2014,33(2):41-43.

[14] 王年,任彬,黄勇,等.基于神经网络的汽车车型图象自动识别[J].中国图象图形学报,1999,4(8),668-672.

[15] LEE K H, HWANG J N, CHEN S I. Model-based vehicle localization based on three-dimensional constrained multiple-kernel tracking[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2015,25(1):38-50.

[16] Wei Wu, Zhang Qisen, Wang Mingjun. A method of vehicle classification using models and nerual networks[J]. IEEE VTS 53rd Vehicular Technology Conference, VTC 2001 Spring, 2001,4:3022-3026.

[17] Lou Jianguang, Tan Tieniu, Hu Weiming, et al. 3-D model-based vehicle tracking[J]. IEEE Transactions on Image Processing, 2005,14(10):1561-1569.

[18] Xu Gang, Zhang Zhengyou. Epipolar geometry in stereo, motion and object recognition: a unified approach[M]. Kluwer Academic Publishers, 1996.

[19] Zhang Zhengyou. A flexible new technique for camera calibration[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2000,22(11):1330-1334.

[20] 焦琴琴,牛力瑶,孙壮文,等.基于车辆声音及震动信号相融合的车型识别[J].微型机与应用,2015,34(11):79-82.

[21] 陈龙威,孙旭飞.一种基于时间序列分层匹配的骑线车辆检测方法[J].微型机与应用,2014,33(21):88-91,94.

上一篇:是德科技首款毫米波/802.11AD

综合设计验证与制造解决方案亮相2016世界移动通信大会

下一篇:基于433

MHz无线自组网的火灾监控报警系统